Поисковый индекс сайта — это база данных, содержащая информацию о веб-страницах, которые поисковая система индексирует и использует для поиска информации. Когда ПС обходит веб-сайты, она анализирует содержимое каждой страницы и добавляет эту информацию в индекс. Он может содержать множество данных, таких как ключевые слова, описание содержимого страницы, заголовки, ссылки на другие страницы и другую информацию.

После индексации, содержимое сайта становится доступным для поиска пользователями в поисковых системах. Когда пользователь вводит запрос в поисковой строке, поисковая система использует свои индексы, чтобы найти соответствующие страницы и показать их в результатах поиска.

Чтобы обеспечить эффективную индексацию вашего сайта, важно создавать качественный контент, использовать ключевые слова, оптимизировать заголовки страниц и мета-описания, а также соблюдать правила построения ссылок на сайте. Все это помогает поисковым системам лучше понимать содержимое вашего сайта и добавлять его в свои индексы.

Индекс поисковых систем – это база (структура) данных, которая содержит информацию о страницах сайтов. Информация заносится в индекс поисковыми роботами, которые учитывают ряд факторов при анализе ресурса:

- качество текстового наполнения,

- графические объекты,

- внутренние и внешние ссылки и т. д.

Когда пользователь вводит свой запрос в строку поиска, система обращается к базе данных за ответом. В это время происходит ранжирование страниц по релевантности – формируется список сайтов от более полезных к менее полезным.

Индексация: что это и как работает

Чтобы понять, что такое индексация сайта, нужно обратиться еще раз к первому определению. Если индекс – это база данных, то индексацией называется процесс сбора и добавления данной информации в нее. Таким образом, создается выжимка документов. Все результаты, которые мы видим в поисковой системе, были бы невозможны без этого процесса. Кстати, он может происходить 2 способами: автоматически и вручную. В первом случае робот самостоятельно находит сайт при переходе по внешним ссылкам с других ресурсов или после сканирования файл-карты sitemap.xml. Во втором случае индексацию инициирует сам владелец ресурса. Для этого ему нужно добавить URL сайта в специальную форму поисковой системы.

Процесс индексации происходит при помощи специальных индексирующих программ («пауков» или «краулеров») поисковых систем. Разберем подробнее это понятие.

Индексирующая программа — это программное обеспечение, которое осуществляет процесс индексации информации в больших объемах данных, таких как документы, веб-страницы, электронные книги и другие типы контента. Она создает структурированный список ключевых слов, терминов или фраз, сопоставленных с соответствующими документами или записями.

Процесс индексации включает в себя анализ и обработку текста, чтобы определить значимые термины и создать связи между ними и соответствующими документами. Это позволяет пользователям быстро находить нужную информацию с помощью поисковых запросов или просматривать содержимое по ключевым словам.

Индексирующие программы широко применяются в информационных системах, библиотеках, поисковых движках, а также в других областях, где требуется эффективное организационное средство для обработки больших объемов данных. Они играют важную роль в упорядочивании и управлении информацией, обеспечивая быстрый доступ к нужным документам или ресурсам.

Необходимость индексировать веб-ресурсы возникла еще в середине 90-х годов прошлого века. Сначала база данных представляла собой подобие предметного указателя с ключевыми словами, найденными на сайтах. Собственно, они и являлись главным элементом ранжирования. Но за 30 лет алгоритм значительно усложнился. Количество сайтов выросло в несколько тысяч раз, и оценка их полезности для пользователей изменилась. Сегодня перед попаданием в индекс информация оценивается с привлечением искусственного интеллекта.

Поисковые роботы: виды, как работают

Поисковый робот (бот, паук, краулер) – это программа, которая выполняет сканирование сайтов. Фактически это основной элемент любой поисковой системы, без которого невозможна ее работа.

Выделяют 2 типа ботов:

- основные – предназначены для сканирования всего контента на сайте и отдельных страницах;

- быстрые – проводят анализ только новой информации, добавленной после очередного обновления.

Еще есть поисковые роботы, которые осуществляют индексацию rss-ленты, медиафайлов и др. Сначала в базу попадают все новые сайты, подходящие под требования поисковой системы. При повторном визите ботов информация только дополняется деталями.

От чего зависит скорость индексации страниц

Чем быстрее веб-ресурс будет проверен роботом и добавлен в индекс, тем лучше для SEO. Скорость зависит как от самих поисковых систем, так и от характеристик сайта. В Яндексе индексация обычно занимает 1–2 недели, в Google – несколько дней. Также на скорость влияет выбор движка сайта и доменной зоны, частота наполнения контентом, внешние и внутренние ссылки, дополнительные инструменты, ограничения в robots.txt, корректно заполненный файл sitemap.xml и др. Для некоторых ресурсов (например, информационных порталов) задействуется специальный робот, который посещает сайт один или даже несколько раз в день.

Как ускорить индексацию сайта? Следуйте основным советам:

- отдайте предпочтение быстрому и надежному хостингу;

- установите правила индексации в файле robots.tx и снимите ненужные запреты;

- устраните дубли и ошибки в коде страниц;

- в корневой папке создайте карту сайта sitemap.xml;

- организуйте простую и понятную навигацию по сайту (желательно, чтобы все страницы были доступны не более чем в 3 клика от главной);

- добавьте сайт в панели веб-мастеров Google и Яндекс;

- создайте эффективную внутреннюю перелинковку страниц;

- регулярно актуализируйте контент;

- зарегистрируйте ресурс в авторитетных рейтингах;

- оцените объем flash-элементов.

Последний пункт связан с тем, что подобные визуальные объекты снижают долю поискового трафика, роботы просто не могут в полной мере выполнить индексацию. Также не рекомендуется размещать ключевую информацию в формате PDF – боты сканируют только текстовое содержимое документа.

Как проверить индексацию страниц сайта

Проверка индексации – первая задача SEO-оптимизации. Ее можно провести следующими способами.

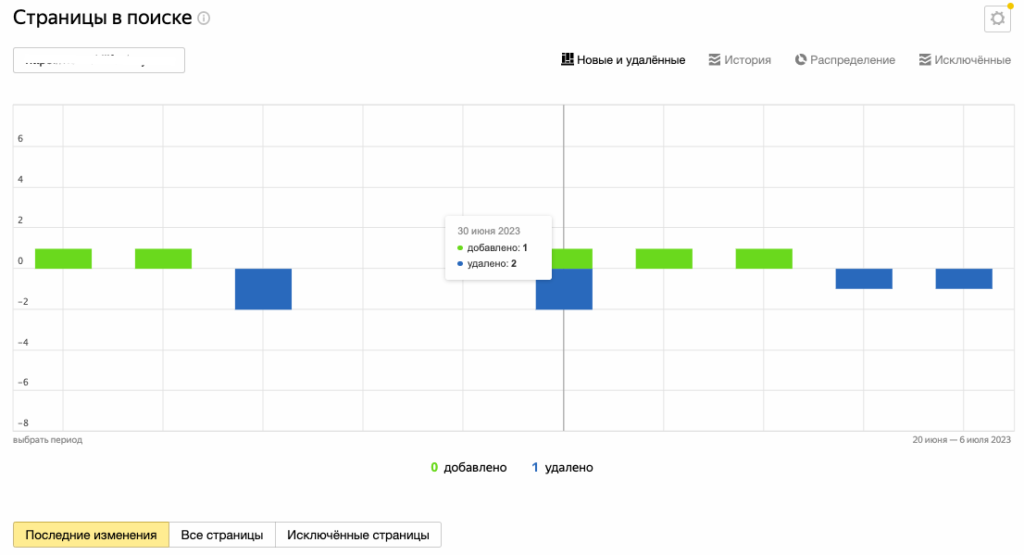

С помощью информации из панели веб-мастеров. Для этого откройте сервисы Google, зайдите в Search Console, а следом в раздел «Индекс Google». Интересующая вас информация находится в блоке «Статус индексирования». Если вы пользуйтесь Яндекс.Вебмастером, пройдите по цепочке: «Индексирование сайта» — «Страницы в поиске».

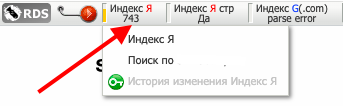

С помощью специальных плагинов. Это дополнения для браузера, позволяющие провести проверку индексации страниц. Наиболее популярным среди них считается RDS Bar.

С помощью поиска по сайту с использованием специальных операторов. Необходимо использовать запрос с конструкцией «site:», после которой указать полный адрес ресурса. Этот способ позволяет вычислить количество проиндексированных страниц. Если от разных поисковых систем вы получили сильно разнящиеся данные, то это сигнал о наличии проблем. Как правило, это говорит о том, что сайт находится под фильтром.